11月27日,南京农业大学薛金林教授团队在Computers and Electronics in Agriculture期刊发表了题为:High-precision Target Ranging in Complex Orchard Scenes by Utilizing Semantic Segmentation Results and Binocular Vision的研究论文。该研究提出了基于多尺度特征融合(Multi-scale Feature Fusion,MsFF)Segformer语义分割模型,同时,结合高精度果园场景语义分割结果,提出了一种结合双目视觉的果园不同目标测距的新方法TPDMR(Target Pixel Depth Mean Ranging)。

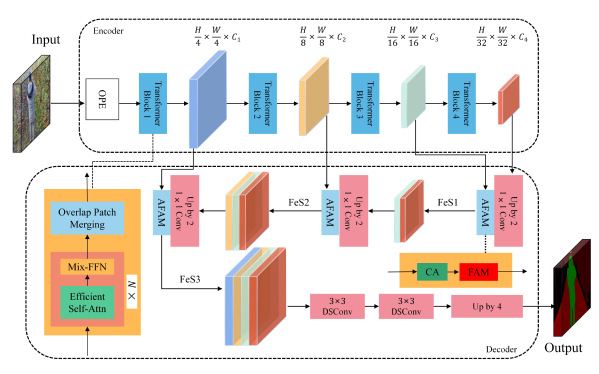

近年来,人工智能(AI)技术的快速发展不断推动果园生产自动化。然而,准确理解语义信息并精确定位果园环境中的各种目标仍然是挑战。目前的研究通常依赖于昂贵的多传感器融合技术或分割效果不足的纯视觉技术。为了解决这些问题,作者提出了一种新的语义分割网络MsFF-Segformer(Multi-scale Feature Fusion Segformer),采用多尺度特征融合来生成高精度语义分割图像。该模型结合了利用纯注意力机制的MiT-B0 编码器和专为多尺度特征融合而设计的MsFF 解码器。MsFF 解码器包含AFAM 模块,可有效对齐相邻尺度的特征。此外,引入通道注意力模块和深度可分离卷积模块,减少模型参数大小,获得语义层次丰富的特征向量,增强果园多尺度目标的分割性能。

图1MsFF-Segformer语义分割网络整体架构

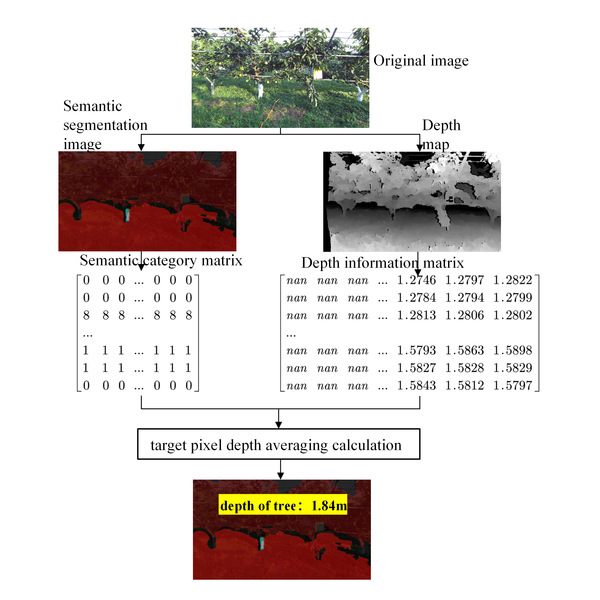

基于果园环境中精确的语义分割结果,作者提出了一种新的方法TPDMR(Target Pixel Depth Mean Ranging),结合双目视觉来估计果园中各种物体的距离。首先,将语义类别矩阵与深度信息矩阵进行匹配。然后,得到表示目标类别的深度信息数组,并过滤掉无效的深度信息。最后,计算目标的平均深度。

图2 TPDMR测距算法流程图

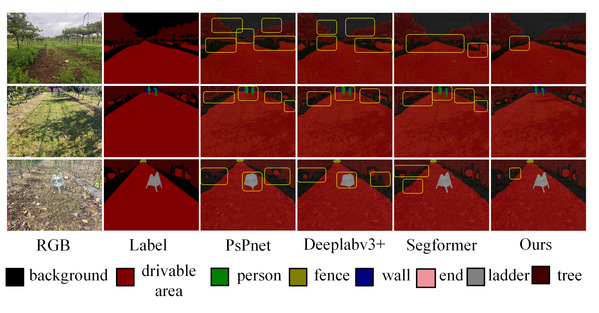

在自制的果园数据集上进行语义分割实验。将结果与PSPnet和其他现有模型的结果进行比较。实验结果表明,该模型的平均交并比(MIoU)达到89.98%,平均像素精度(MPA)达到94.96%。参数量和检测一幅图像所需的时间仅为15.1M和0.019秒,较U-net、Deeplabv3+、Hrnet模型分别减少了84.1%、32.5%、5.9%和69.4%、59.7%、64.2%。采用TPDMR算法在果园内对不同目标进行测距实验。结果表明,所有目标类别的测距误差均小于6%,体现了较高的准确性和稳定性。此外,整体算法的运行时间约为0.8 s,表明性能高效。

图3 不同的果园、障碍物以及果园边界

图4自制果园数据集上的分割效果对比

本文的第一作者为南京农业大学工学院研究生温瑜,通讯作者为薛金林教授。博士研究生孙晗、宋悦、吕鹏飞、刘少华,硕士研究生褚阳阳、张田煜参与研究。该成果得到江苏省现代农业产业技术体系、南京市现代农机装备与技术创新示范项目资助。